1) Evolución

Un dispositivo de almacenamiento computacional que es capaz de almacenar datos o cualquier tipo de información. Históricamente se ha usado el papel como método más común, pero actualmente es posible almacenar digitalmente en un CD por ejemplo, los datos que cabrían en miles de carpetas archivadas. A lo largo de la historia se ha buscado el camino al conocimiento y sus consecuencias de encontrar el sistema más pequeño físicamente y con más capacidad para almacenar más datos y tratarlos rápidamente.

También conocido como circuito integrado. Se desarrolló por primera vez en 1958 por el ingeniero Jack Kilby justo meses después de haber sido contratado por la firma Texas Instruments. Se trataba de un dispositivo de germanio que integraba seis transistores en una misma base semiconductora para formar un oscilador de rotación de fase. En el año 2000, Kilby obtuvo el Premio Nobel de Física por la contribución de su invento al desarrollo de la tecnología de la información.

Un microchip es una pastilla muy delgada donde se encuentran miles o millones de dispositivos electrónicos interconectados, principalmente diodos y transistores, y también componentes pasivos como resistores o condensadores. Su área puede ser de 1 cm, 2 cm o inferior. Los microchips son quizás los sistemas de almacenamiento más empleados, hoy en día se utilizan además de en los computadores, en los teléfonos móviles, electrodomésticos, juguetes con algún componente electrónico, etc.

El transistor actúa como interruptor. Puede encenderse o apagarse electrónicamente o amplificar corriente. Se usa en computadoras para almacenar información o en amplificadores para aumentar el volumen de sonido. Las resistencias limitan el flujo de electricidad y nos permiten controlar la cantidad de corriente que fluye, esto se usa por ejemplo para controlar el volumen de un televisor o radio.

El desarrollo del microchip es especialmente importante en la historia, pues es algo increíblemente pequeño que puede almacenar cantidad de datos inmensas, que hace años era impensable. Se necesita un desarrollo a nivel microscópico para diseñar los microchips.

El primer computador que usó microchips fue un IBM lanzado en 1965, llamado serie 360. Estas computadoras se consideran de la tercera generación de computadoras, y sustituyeron por completo a las de segunda generación, introduciendo una manera de programar que aún se mantiene en grandes computadoras de IBM.

2) Tipos y descripción

* Memoria Ram (Ramdom Access Memory) :

La Memoria de Acceso Aleatorio, o RAM (acrónimo inglés de Random Access Memory), es una memoria de semiconductor, en la que se puede tanto leer como escribir información. Es una memoria volátil, es decir, pierde su contenido al desconectarse de la electricidad.

La memoria RAM es el componente de almacenamiento más importante de un computador actual, junto al disco duro. Con la llegada de los computadores de escritorio, había que idear un sistema de almacenamiento que no ocupara espacio, pues los computadores de escritorio se idearon para que cupiesen en una mesa de oficina. La memoria RAM se forma a partir de microchips con entradas de memoria. La memoria es almacenada en esas entradas de manera aleatoria, de ahí su nombre. La memoria RAM es uno de los componentes informáticos que más ha evolucionado en los últimos veinte años. Si a finales de los 80 la capacidad de las memorias RAM rondaban los 4 MB, ahora lo normal es comprarse un computador con al menos 1024 MB, (1 GB). Normalmente se ha ido avanzando en una cantidad de MB igual a potencias de 2. A mediados de los 90, con la llegada de Windows 95, los computadores comenzaron a usar memorias de 16 MB de RAM, más tarde de 32, 64, 128… hasta los Pentium 4 y usando Windows XP, en donde se recomienda al menos 256 MB de RAM, aunque hoy en día lo normal es que usen 1 gigabyte o más.

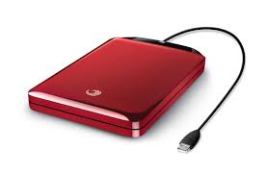

* Disco duro :

Es el medio de almacenamiento por excelencia. Desde que en 1955 saliera el primer disco duro hasta nuestros días, el disco duro o HDD ha tenido un gran desarrollo. Los discos duros se emplean en computadores de escritorio, portátiles y unidades de almacenamiento de manejo más complejo. El disco duro es el componente que se encarga de almacenar todos los datos que queremos. Mientras que la memoria RAM actúa como memoria “de apoyo” (como variable que almacena y pierde información según se van procesando datos), el disco duro almacena permanentemente la información que le metemos, hasta que es borrado. Generalmente, lo primero que se graba en un disco duro es el sistema operativo que vamos a usar en nuestro computador. Una vez tenemos instalado el sistema operativo en el disco duro, podemos usar todos los programas que queramos que hayan instalados, y toda la información que queramos guardar se almacenará en el disco duro. En el disco duro almacenamos cualquier cosa, como documentos, imagen, sonido, programas, vídeos, ficheros, etc.

Los discos duros también han evolucionado muchísimo en los últimos veinte años, sobre todo ampliando su capacidad

El disco duro está compuesto básicamente de:

– Varios discos de metal magnetizado, que es donde se guardan los datos.

– Un motor que hace girar los discos.

– Un conjunto de cabezales, que son los que leen la información guardada en los discos.

– Un electroimán que mueve los cabezales.

– Un circuito electrónico de control, que incluye el interface con el ordenador y la memoria caché.

– Una caja hermética (aunque no al vacío), que protege el conjunto.

Normalmente usan un sistema de grabación magnética analógica.

El número de discos depende de la capacidad del HDD y el de cabezales del numero de discos x 2, ya que llevan un cabezal por cada cara de cada disco (4 discos = 8 caras = 8 cabezales).

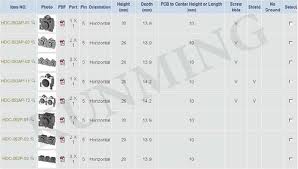

Actualmente el tamaño estándar es de 3.5′ de ancho para los HDD de pcs y de 2.5′ para los discos de ordenadores portátiles.

* Dispositivos portátiles :

Además de los dispositivos fijos que existen como componentes en una computadora, hay otros que pueden introducirse y sacarse en cualquier computador. Estos sistemas son realmente útiles para transportar información entre dos o más computadoras.

* Disquete

También llamado disco flexible (floppy disk en inglés). A simple vista es una pieza cuadrada de plástico, en cuyo interior se encuentra un disco flexible y magnético, bastante frágil. Los disquetes se introducen en el computador mediante la disquetera.

En los años 80 gozaron de gran popularidad. Los programas informáticos y los videojuegos para PC se distribuían en este formato. Ya que en aquella época los programas y juegos no llegaban ni a 1 MB, cabían perfectamente en los disquetes. En su día existió un disquete rectangular, y más tarde apareció el disquete de 3 1/2 pulgadas, el popular disquete cuadrado. En los noventa, los programas comenzaron a ocupar más memoria, por lo que en algunos casos se necesitaban varios disquetes para completar una instalación.

El disquete es un sistema de almacenamiento magnético, al igual que los casetes o los discos duros, y aunque han gozado de gran popularidad desde los 80 hasta ahora, pero ya son obsoletos. De hecho, algunos computadores ya salen de fábrica sin disquetera, pues los disquetes se han quedado pequeños en cuanto a capacidad y velocidad. Teniendo en cuenta lo que ocupan los programas actuales, un disquete hoy en día solo sirve para almacenar algunos documentos de texto, imágenes y presentaciones.

* CD ROM

Es un disco compacto (del inglés: Compact Disc – Read Only Memory). Se trata de un disco compacto (no flexible como los disquetes) óptico utilizado para almacenar información no volátil, es decir, la información introducida en un CD en principio no se puede borrar. Una vez un CD es escrito, no puede ser modificado, sólo leído (de ahí su nombre, Read Only Memory). Un CD-ROM es un disco de plástico plano con información digital codificada en espiral desde el centro hasta el borde. Fueron lanzados a mediados de los 80 por compañías de prestigio como Sony y Philips. Microsoft y Apple fueron dos de las grandes compañías informáticas que la utilizaron en sus comienzos. Es uno de los dispositivos de almacenamiento más utilizados. De hecho, fue el sustituto de los casetes para almacenar música, y de los disquetes para almacenar otro tipo de datos.

Hay varios tipos de CD-ROM. Los clásicos miden unos 12 centímetros de diámetro, y generalmente pueden almacenar 650 o 700 MB de información. Sin embargo en los últimos años también se han diseñado CD-ROMS con capacidades de 800 o 900 MB. Si tenemos en cuenta la capacidad en minutos de música, serían 80 minutos los de 700 MB, por ejemplo. También existen discos de 8 cm con menos capacidad, pero ideales para almacenar software relativamente pequeño. Generalmente se utilizan para grabar software, drivers, etc. de periféricos o similares, aunque también se usan para transportar datos normalmente como los CD normales.

La principal ventaja del CD-ROM es su versatilidad, su comodidad de manejo, sus pequeñas dimensiones (sobre todo de grosor). Sin embargo sus principal inconveniente es que no pueden manipularse los datos almacenados en él. Con el fin de solucionar este problema aparecieron los CD-RW, o CD regrabable. Sus características son idénticas a los CD normales, pero con la peculiaridad de que pueden ser escritos tantas veces como se quiera. Los CD son leídos por lectores de CD, que incluyen un láser que va leyendo datos desde el centro del disco hasta el borde. El sistema es parecido al de las tarjetas perforadas. Mientras que una tarjeta perforada es claramente visible sus agujeros, en un cd también se incluyen micro perforaciones que son imperceptibles a simple vista, pues son microscópicas. A la hora de escribir en un CD, se emplea el sistema binario con perforación o no perforación (ceros y unos).

* DVD

El crecimiento tecnológico en la informática es tal que incluso los CD se han quedado pequeños. Si hace 10 años los disquetes se habían quedado pequeños y parecía que un CD era algo demasiado grande, algo ha cambiado, pues todas las aplicaciones, ya sean programas, sistemas operativos o videojuegos ocupan mucha más memoria. De los tradicionales 700MB de capacidad de un CD se pasaron a los 4,7 GB de un DVD. La primera ráfaga de ventas de DVD aparecieron para formato vídeo, para sustituir a los clásicos VHS . Las ventajas de los DVD eran claras, a más capacidad, mejor calidad se pueden almacenar. Y mejor se conservan los datos, ya que las cintas magnétiicas de los videocasetes eran fácilmente desgastables. Un DVD es mucho más durarero, su calidad de imagen es mejor y también la calidad de sonido. Las películas en DVD comenzaron a popularizarse a finales de los años 90.

Sin embargo en esos años aún los CD eran los más populares a nivel informático. Un videojuego solía ocupar unos 600mb de instalación, con lo que fácilmente cabía en un CD. Pero poco a poco los videojuegos y otros programas comenzaron a ocupar más, ya que conforme va avanzando la tecnología de datos, gráficos, etc. más memoria se necesita. Algunos videojuegos llegaban a ocupar 4 o 5 cds, lo que hacía muy incómodo su manipulación. Finalmente se ha decidido por fin que aquellos programas que ocupen más memoria de lo que cabe en un CD, sea almacenado en un DVD. Los DVD son más caros que los CD, aunque poco a poco se están haciendo con el mercado. Quizás sean los sustitutos definitivos de los CD, aunque por ahora estos últimos no están decayendo en absoluto. La venta de CD vírgenes sigue siendo abrumadora. Sin embargo se ha disparado la venta de DVD, pues cada vez más la gente empieza a grabar más datos y lógicamente se busca el menor espacio posible. Y si en un DVD se pueden almacenar seis películas, mejor que usar seis CD.

También existen los DVD-R, ya que al igual que los CD, el DVD normal es de sólo lectura. Pero con la lección aprendida de los CD, se diseñaron los DVD regrabables. Además, hace unos años que existen los DVD de doble capa. Este tipo de DVD siguen leyendo por una cara, pero con doble capa de datos. Pero también existen DVD que se pueden leer por las dos caras. Los hay de doble cara y una capa, pero si el DVD es de doble cara y doble capa por cada una, la capacidad llega a los 17 gb. Sin embargo aún estos sistemas se utilizan mínimamente, son muy caros, pero seguramente algún día sustituirán a los actuales CD.

* Memoria USB

La Memoria USB fue inventada en 1998 por IBM, pero no fue patentada por él. Su objetivo era sustituir a los disquetes con mucha más capacidad y velocidad de transmisión de datos.Aunque actualmente en un CD o DVD se puede almacenar memoria para luego borrarla y manipularla, lo más cómodo y usado son las memorias USB. Son pequeños dispositivos del tamaño de un mechero que actúan prácticamente igual que un disquete, pero con una capacidad mucho mayor, que actualmente van desde los 64 mb a varios gigabytes. Su principal ventaja es su pequeño tamaño, su resistencia (la memoria en sí está protegida por una carcasa de plástico como un mechero) y su velocidad de transmisión, mucho más rápido que los disquetes.

Actualmente está muy de moda este tipo de dispositivos, sobre todo entre jóvenes u oficinistas, pues gracias a su reducido tamaño y forma puede colgarse como llavero por ejemplo, y lo más importante, con los sistemas operativos (Linux,Windows o Mac), sólo hay que conectarlo al computador y usarlo sin más complicaciones. Además existen otros aparatos como los reproductores de MP3 que utilizan las mismas características. Pueden almacenar cualquier tipo de dato, pero su principal característica es que los ficheros de música en formato mp3 y wma sobre todo, son reconocidos y procesados para ser escuchados a través de unos auriculares conectados al aparato. Esto es pues, un sustituto del walkman. Pero además cada vez están apareciendo nuevos diseños que son capaces de almacenar ya decenas de gigabytes (miles de canciones) y también vídeo, que con una pequeña pantalla pueden ser visualizados.

3) Tipos de conexiones

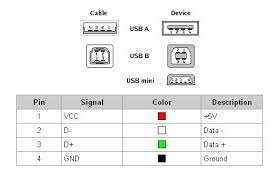

- USB 2.0 es la conexión más universal ya que no hay equipo que no integre dicho puerto de conexión. La velocidad teórica máxima de dicha conexión es de 60MB/s.

- USB 3.0 es la nueva versión. Un estándar que aumenta notablemente la velocidad consiguiendo un máximo teórico de transferencia de 640MB/s. Como podéis ver casi 11 veces más rápida que la versión 2.0. El conector USB 3.0 es retrocompatible con USB 2.0

- Firewire 400 es otro tipo de conexión. Apple la creo y popularizó siendo usada por numerosas videocámaras convirtiendo el estándar en el más ideal para temas de vídeo gracias a que la transferencia se hace a una velocidad sostenida. La velocidad teórica máxima es de 50MB/s.

- Firewire 800 es la versión mejorada que duplica la velocidad de transferencia, llegando hasta los 100MB/s.

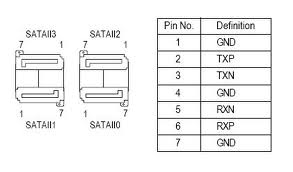

- eSata es la versión externa del conector SATA. La velocidad máxima que alcanza son 384 MB/s lo que la hace realmente interesante.

4) Como se conectan a la placa base

1 Apaga tu ordenador asegúrate de desconectar todos los cables de corriente.

2 Abre la tapa del gabinete del ordenador. Los tornillos y tuercas que pueda tener varían de un modelo a otro.

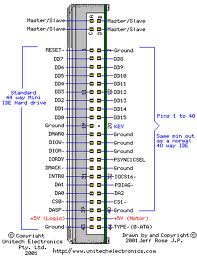

3 Ahora en la regrabadora/lectora IDE deb erás ver la posición de los jumpers dependiendo de cómo quieras instalarlo, ya sea como maestro, esclavo, o cable selector. Las instrucciones del jumper están por lo general en el dorso de la misma regrabadora/lectora.

4 Una vez la hayas jumpeado correctamente, posiciona regrabadora/lectora en la bandeja reservada para la misma que se encuentra dentro del gabinete. Por lo general están arriba de todo.

5 Asegura la regrabadora/lectora a la bandeja usando tornillos.

6 Conecta un extremo del cable IDE a la placa madre. El cable IDE por lo general es blanco con el conector negro.

7 Conecta el otro extremo del cable IDE a la regrabadora/lectora.

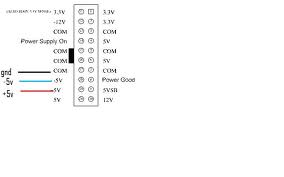

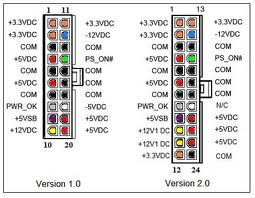

8 Conecta el cable de alimentación a la regrabadora/lectora. Este cable sale de la fuente de alimentación del ordenador y su conector es por lo general blanco y un poco más pequeño que el del cable IDE.

9 Vuelve a conectar los cables de corriente y enciende tu ordenador. Si has instalado tu regrabadora/lectora IDE en tu ordenador de escritorio correctamente, el nombre de la mismo debería aparecer cuando el ordenador inicia.

5) Explicar como conectar dos unidades de CD/DVD a un mismo cable.

- Colócate una pulsera antiestática para proteger la unidad de CD-ROM y el disco duro de daños electrostáticos. Inserta un extremo del cable de cinta IDE en la ranura IDE1 o ATA1 en la tarjeta madre.

- Comprueba la configuración de los puentes en la parte posterior del disco duro. Comparar la configuración con el diagrama de puente encontrado en el manual del dispositivo. Confirma que el disco duro esté configurado como el dispositivo maestro.

- Revisa la configuración de los puentes en la parte posterior de la unidad de CD-ROM. Confirma que el CD-ROM esté configurado como el dispositivo esclavo.

- Introduce el otro extremo del conector IDE en la ranura IDE en la parte posterior del disco duro. Inserta el conector medio IDE en la unidad de CD-ROM.

6) Futuras unidades de almacenamiento

El futuro no está tan lejos como podemos pensar, por ello, destacamos tres de las noticias más novedosas e interesantes que hemos encontrado.

* Almacenamiento convergente de HP

* Cristales de memoria

* Mini memorias flash con grafeno

3) Ordenar los cables

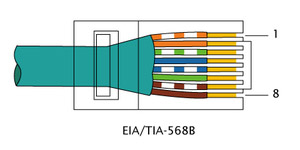

3) Ordenar los cables  4. Cortarlos e introducirlos con cuidado en la clavija RJ-45

4. Cortarlos e introducirlos con cuidado en la clavija RJ-45  5. Fijar con la crimpadora

5. Fijar con la crimpadora  6. Repetir con el otro extremo y comprobar

6. Repetir con el otro extremo y comprobar  5) Cat 5 : Su velocidad de transferencia es de 100 mbytes. Cat 5 E : Su velocidad de transferencia es de 165 mbytes. HUB: Su velocidad de transferencia es de 10 mbytes 6) Un switch es un dispositivo cuyo cometido es conectar varios elementos dentro de una red 7) Al Switch se le denomina puente multipuerto, así como el hub se denomina repetidor multipuerto.La diferencia entre el hub y el switch es que los switches toman decisiones basándose en las direcciones MAC y los hubs no toman ninguna decisión. Como los switches son capaces de tomar decisiones, así hacen que la LAN sea mucho más eficiente. Los switches hacen esto “conmutando” datos sólo desde el puerto al cual está conectado el host correspondiente. A diferencia de esto, el hub envía datos a través de todos los puertos de modo que todos los hosts deban ver y procesar (aceptar o rechazar) todos los datos. Esto hace que la LAN sea mas lenta. A primera vista los switches parecen a menudo similares a los hubs. Tanto los hubs como los switches tienen varios puertos de conexión (pueden ser de 8, 12, 24 o 48, o conectando 2 de 24 en serie), dado que una de sus funciones es la concentración de conectividad (permitir que varios dispositivos se conecten a un punto de la red). La diferencia entre un hub y un switch está dada por lo que sucede dentro de cada dispositivo. 8)

5) Cat 5 : Su velocidad de transferencia es de 100 mbytes. Cat 5 E : Su velocidad de transferencia es de 165 mbytes. HUB: Su velocidad de transferencia es de 10 mbytes 6) Un switch es un dispositivo cuyo cometido es conectar varios elementos dentro de una red 7) Al Switch se le denomina puente multipuerto, así como el hub se denomina repetidor multipuerto.La diferencia entre el hub y el switch es que los switches toman decisiones basándose en las direcciones MAC y los hubs no toman ninguna decisión. Como los switches son capaces de tomar decisiones, así hacen que la LAN sea mucho más eficiente. Los switches hacen esto “conmutando” datos sólo desde el puerto al cual está conectado el host correspondiente. A diferencia de esto, el hub envía datos a través de todos los puertos de modo que todos los hosts deban ver y procesar (aceptar o rechazar) todos los datos. Esto hace que la LAN sea mas lenta. A primera vista los switches parecen a menudo similares a los hubs. Tanto los hubs como los switches tienen varios puertos de conexión (pueden ser de 8, 12, 24 o 48, o conectando 2 de 24 en serie), dado que una de sus funciones es la concentración de conectividad (permitir que varios dispositivos se conecten a un punto de la red). La diferencia entre un hub y un switch está dada por lo que sucede dentro de cada dispositivo. 8)